韩联社首尔3月6日电 韩国研究团队全球最初研发出即可减少电耗,又可超高速处理大语言模型(LLM)的人工智能(AI)半导体核心技术“互补型转换器”(Complementary-Transformer)。

韩国科学技术信息通信部6日表示,韩国科学技术院(KAIST)PIM半导体研究中心和人工智能半导体研究生院柳会峻教授研究小组凭借三星电子28纳米工艺开发出互补型转换器。

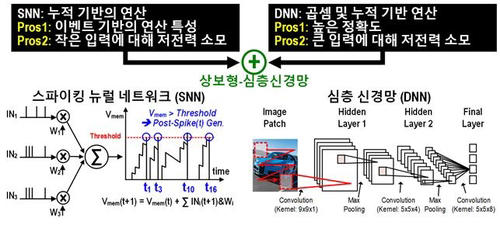

所谓“互补型转换器技术”,是指选择性使用模仿人脑结构与功能设计而成的脉冲神经网络(SNN)和深度神经网络(DNN),实现转换功能的技术。转换器(Transformer)也是积累文章内词汇等数据内部关系进而学习条理和含义的神经网络,属于ChatGPT的原创技术。

图:脉冲神经网络和深度神经网络的互补特性 韩国科学技术信息通信部供图 来源:韩联社

诸如GPT的大语言模型,其间通过大量的图片处理器(GPU)和250瓦特的电耗才能实现驱动,但此次研究小组成功在一个4.5毫米×4.5毫米的小型人工智能半导体内,以400毫瓦的超低电耗实现了超高速驱动。

该研究结果在上月19日至23日美国旧金山举行的国际固态电路会议(ISSCC)上公开并演示。研究小组介绍称,将神经形态计算技术的准确度提升至与卷积神经网络(CNN)相同的水平,并运用了可适用于诸多应用领域的互补型深度神经网络(C-DNN)。

科技部介绍称,研究小组将互补型深度神经网络技术用于大语言模型,实际验证了超低电耗、高性能的端侧人工智能(On-device AI)能够存在,全球首次以人工智能半导体的形式呈现出此前仅停留在理论阶段的研究内容。

据研究小组介绍,互补型转换器使用的电力仅为NVIDIA A100图片处理器625分之1的水平,利用GPT-2模型生成语言时仅需0.4秒,利用T5翻译语言只需0.2秒。研究小组计划今后扩大研究范围,将神经形态计算技术从语言模型拓展至更多应用领域。